大数据workshop:《云数据·大计算:海量日志数据分析与应用》之《数据采集:日志数据上传》篇...

本文共 3453 字,大约阅读时间需要 11 分钟。

大数据workshop:《云数据·大计算:海量日志数据分析与应用》之《数据采集:日志数据上传》篇

实验背景介绍

2017云栖大会·成都峰会 TechInsight & Workshop.

本手册为云栖大会Workshop《云计算·大数据:海量日志数据分析与应用》的《数据采集:日志数据上传》篇而准备。主要为保障各位学员在workshop当天能够顺畅进行动手实操,那么本节为学员掌握阿里云数据采集的操作和使用。

实验涉及大数据产品

- 大数据计算服务

- 大数据开发套件

实验环境准备

必备条件:首先需要确保自己有阿里云云账号并已实名认证。详细点击:

开通大数据计算服务MaxCompute

若已经开通和购买了MaxCompute,请忽略次步骤直接进入创建Data IDE项目空间。

- step1:进入并点击右上角登录阿里云账号。

- step2:进入大数据计算服务产品详情页,点击立即开通。

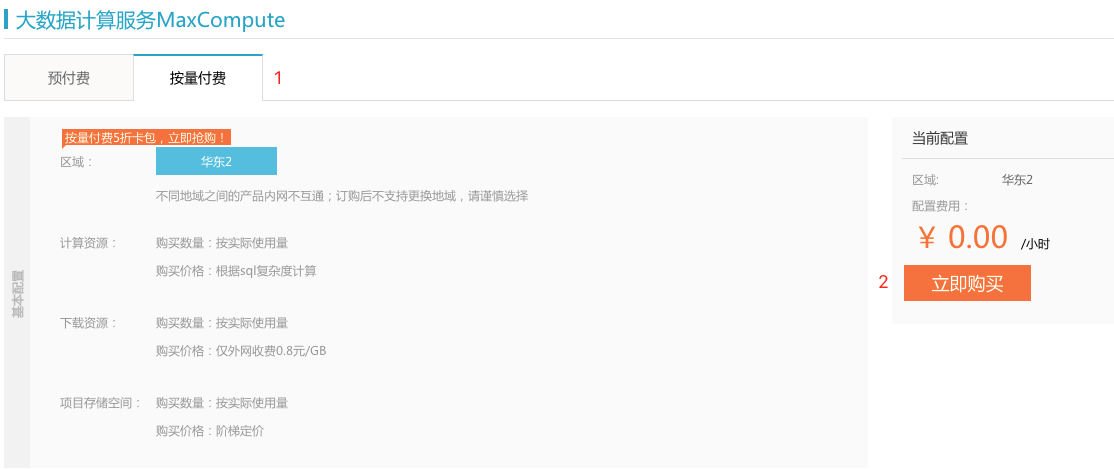

- step3:选择按量付费并点击立即购买。

创建Data IDE项目空间

确保阿里云账号处于登录状态。

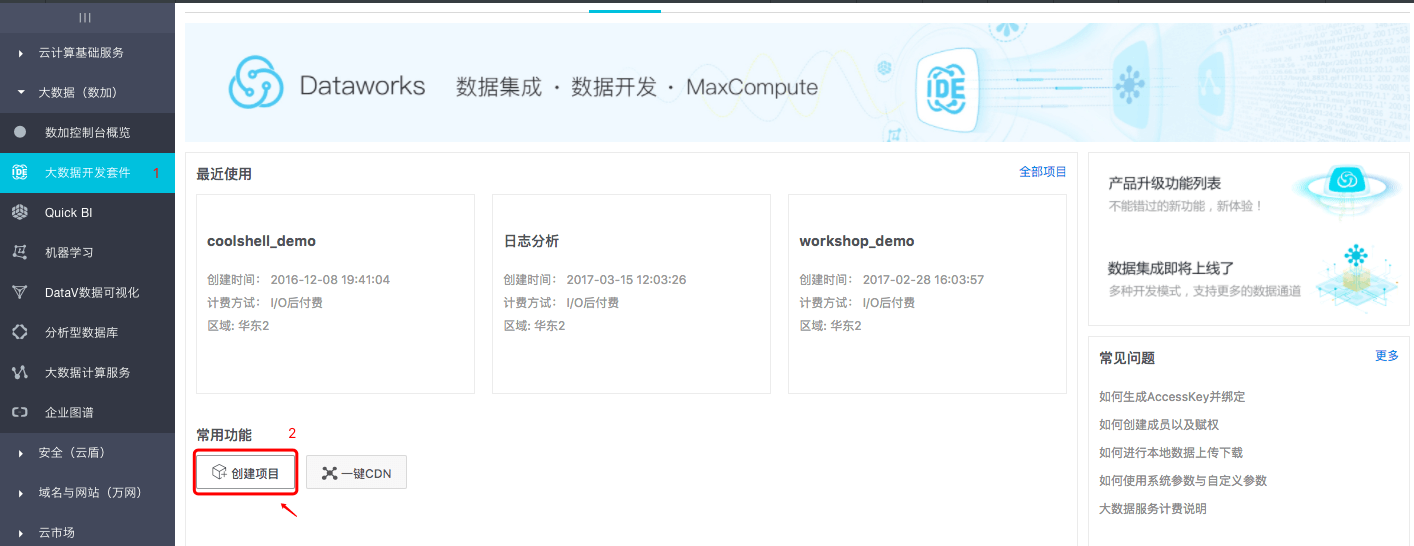

- step1:大数据(数加)管理控制台>大数据开发套件tab页面下。

- step2:点击创建项目,跳出创建项目对话框。

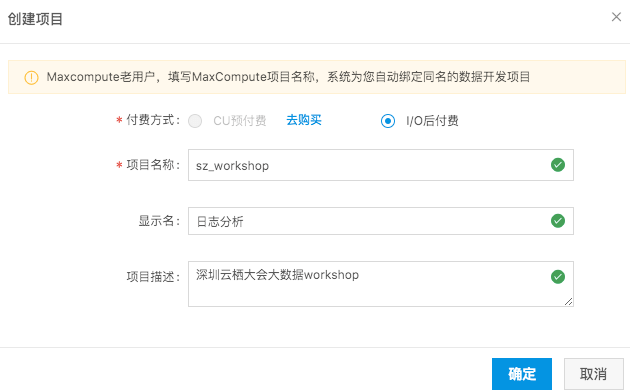

- step3:勾选付费方式为I/O后付费,填写项目名称及相关信息,点击确定,直至返回创建成功状态。

项目名需要字母或下划线开头,只能包含字母下划线和数字。

【注意】项目名称全局唯一,建议大家采用自己容易区分的名称来作为本次workshop的项目空间名称。

进入大数据开发套件

确保阿里云账号处于登录状态。

- step1:大数据开发套件项目列表。

- step2:点击已经创建的项目空间名称,进入大数据开发套件。

新建数据源

根据workshop模拟的场景,需要分别创建FTP数据源和RDS数据源。

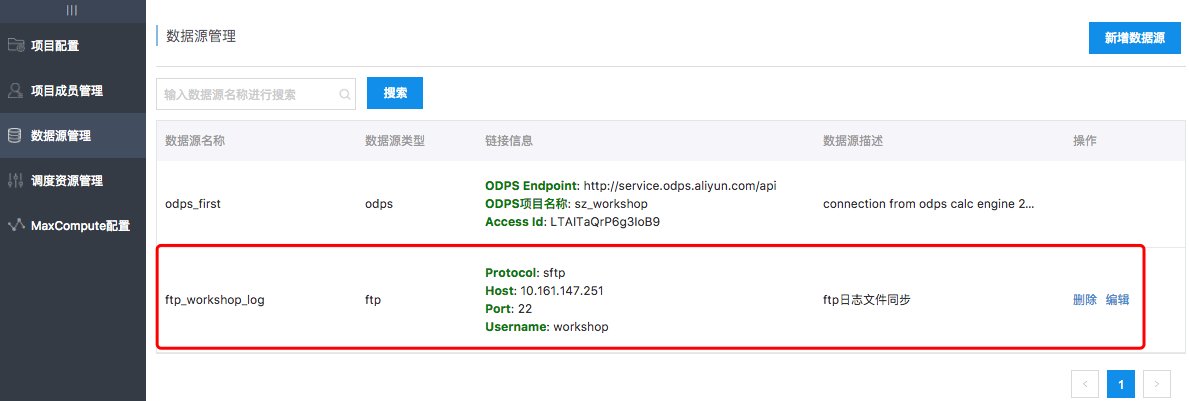

1.新建FTP数据源

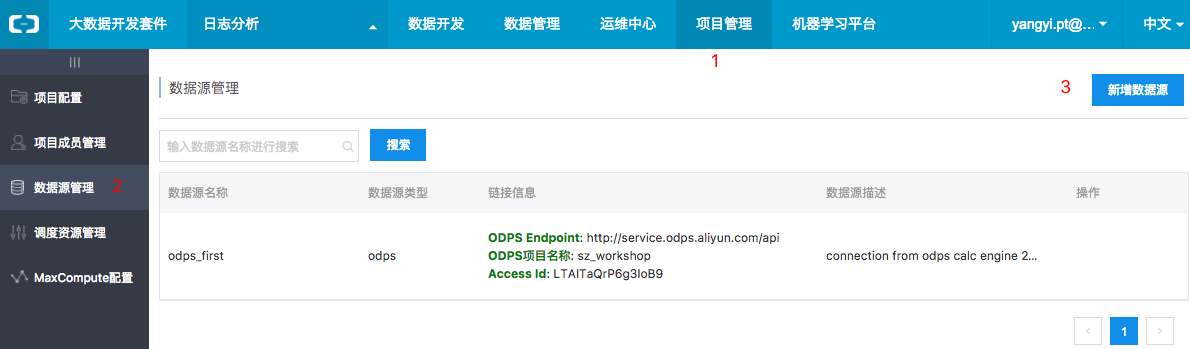

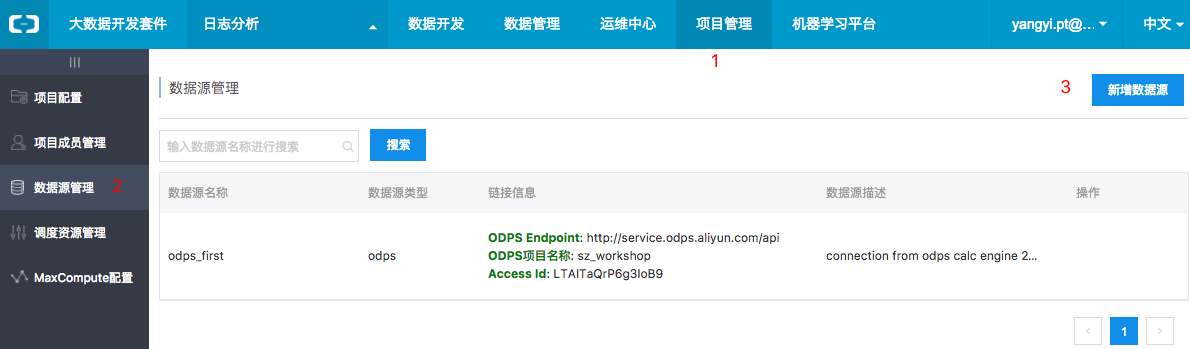

- step1:点击项目管理>数据源管理,继而点击新增数据源。

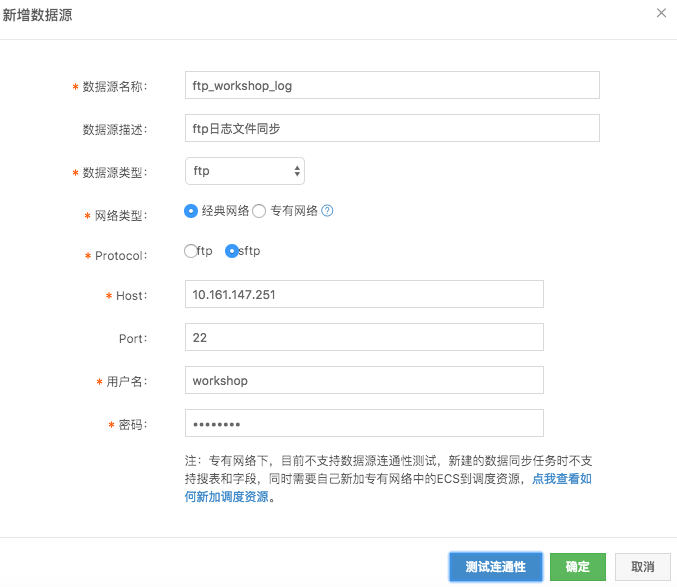

- step2:选择数据源类型ftp,同时Protocol选择为sftp,其他配置项如下。

FTP数据源配置信息如下:

- 数据源名称:ftp_workshop_log

- 数据源描述:ftp日志文件同步

- 数据源类型:ftp

- 网络类型:经典网络

- Protocol:sftp

- Host:10.161.147.251

- Port:22

- 用户名/密码:workshop/workshop

- step3:点击测试连通性,连通性测试通过后,点击确定保存配置。

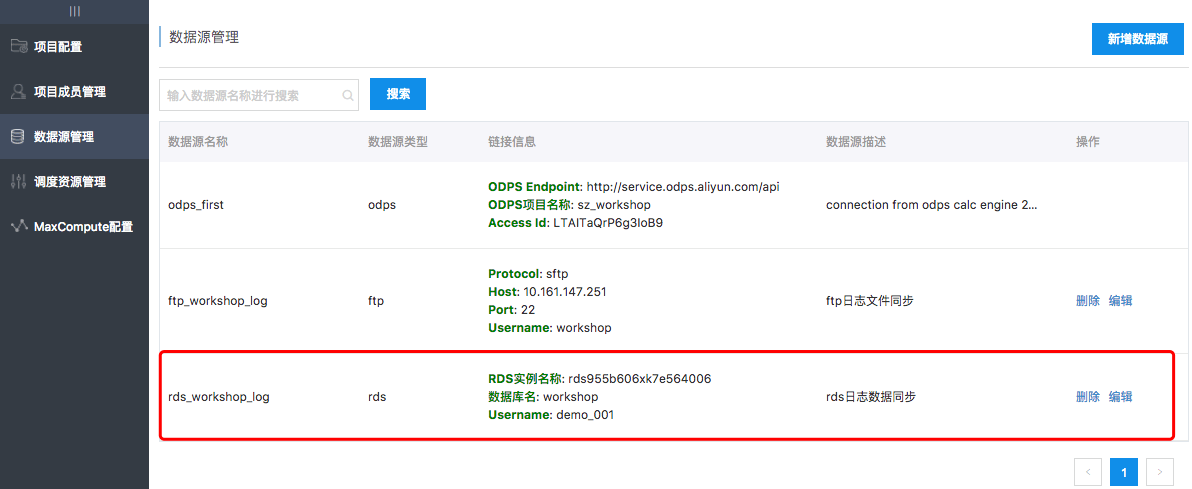

2.新建RDS数据源

- step1:点击项目管理>数据源管理,继而点击新增数据源。

- step2:选择数据源类型为RDS>mysql并完成相关配置项。

RDS数据源配置信息如下:

- 数据源名称:rds_workshop_log

- 数据源描述:rds日志数据同步

- 数据源类型:RDS > Mysql

- RDS实例名称:rds955b606xk7e564006

- RDS实例购买者ID:1805651026304759

- 数据库名:workshop

- 用户名/密码:demo_001/demo_001

- step3:点击测试连通性,连通性测试通过后,点击确定保存配置。

创建目标表

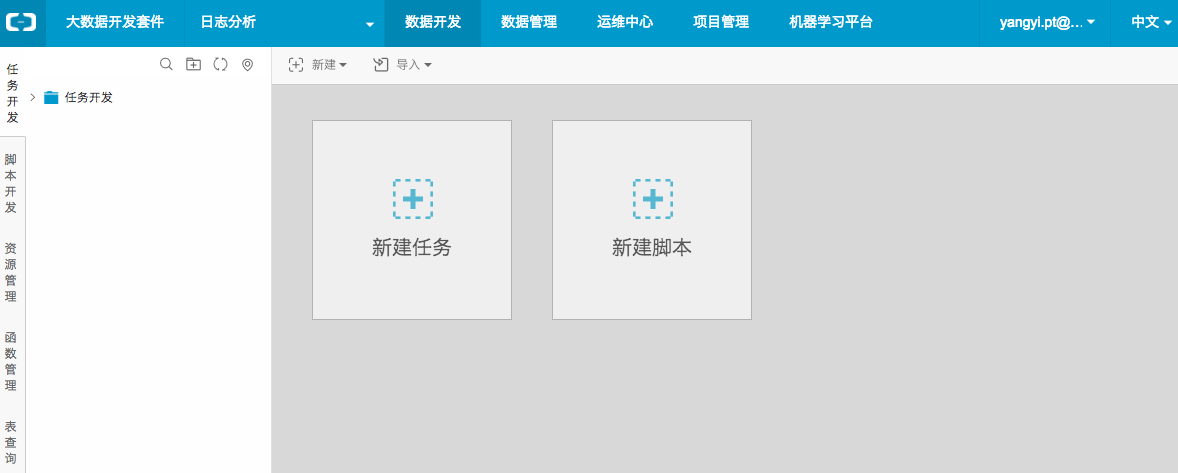

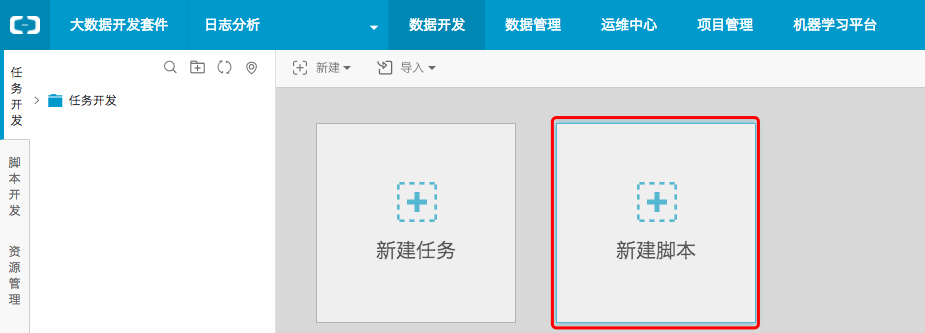

- step1:点击数据开发,进入数据开发首页中点击新建脚本。

- step2:配置文件名称为create_table_ddl,类型选择为ODPS SQL,点击提交。

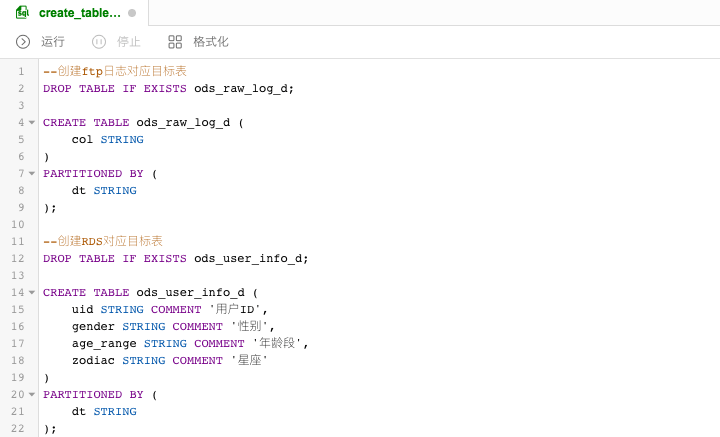

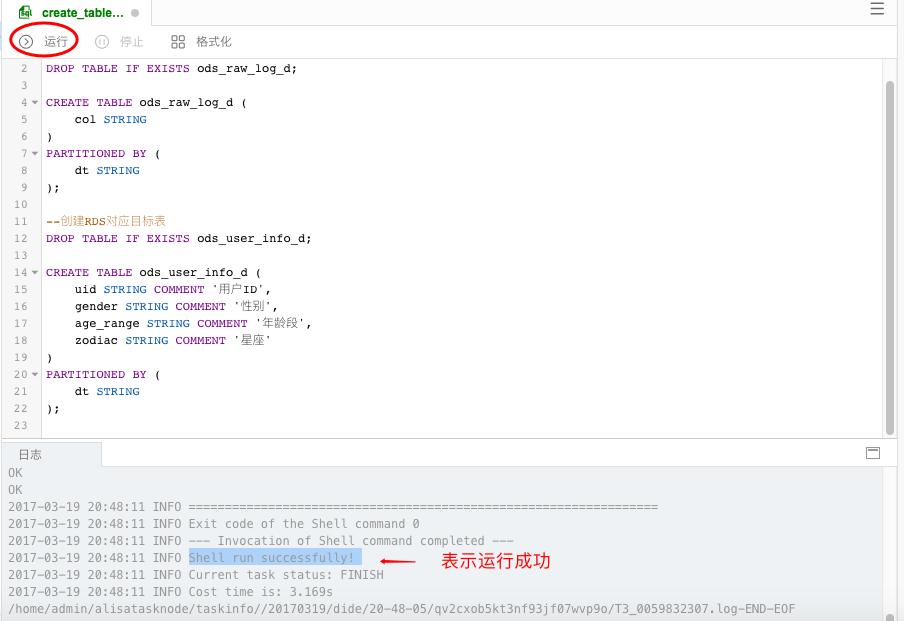

- step3:编写DDL创建表语句,如下分别创建FTP日志对应目标表和RDS对应目标表.

DDL语句如下:

--创建ftp日志对应目标表DROP TABLE IF EXISTS ods_raw_log_d;CREATE TABLE ods_raw_log_d ( col STRING)PARTITIONED BY ( dt STRING);--创建RDS对应目标表DROP TABLE IF EXISTS ods_user_info_d;CREATE TABLE ods_user_info_d ( uid STRING COMMENT '用户ID', gender STRING COMMENT '性别', age_range STRING COMMENT '年龄段', zodiac STRING COMMENT '星座')PARTITIONED BY ( dt STRING);

- step3:点击运行,直至日志信息返回成功表示两张目标表创建成功。

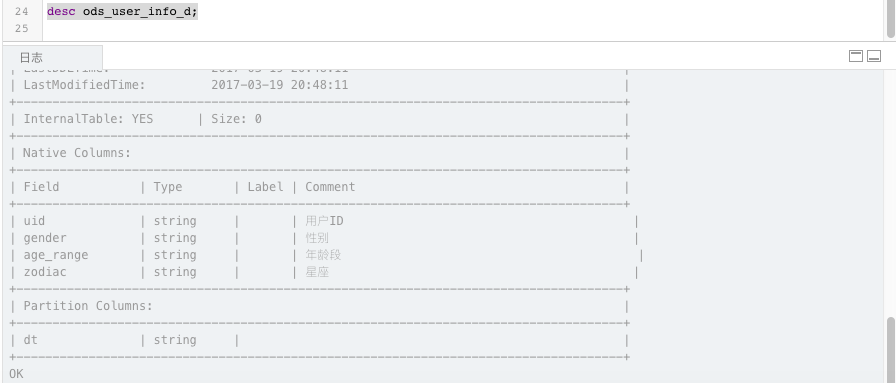

- step4:可以使用desc语法来确认创建表是否成功。

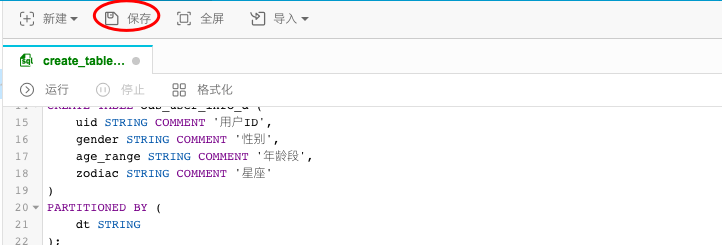

- step5:点击保存,保存编写的SQL建表语句。

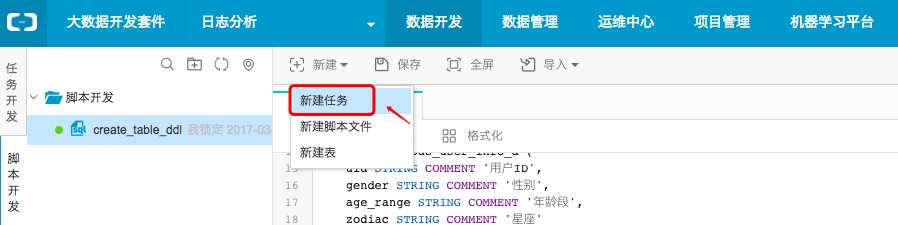

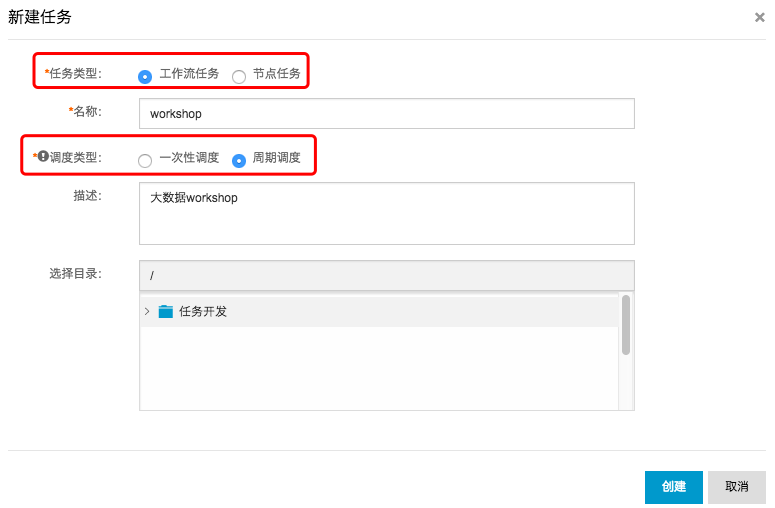

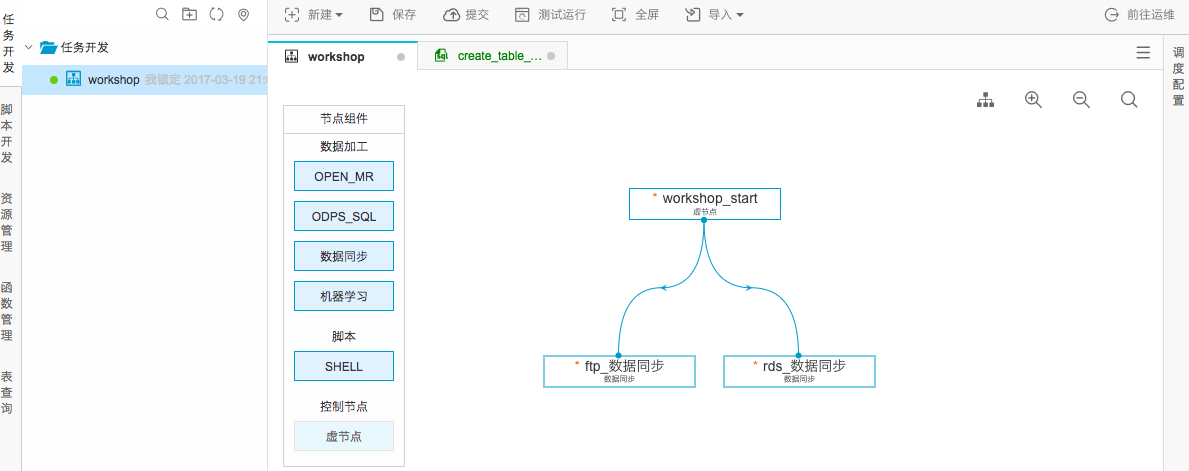

新建工作流任务

- step1:点击新建并选择新建任务。

- step2:选择工作流任务,调度类型选择为周期调度,其他配置项如下。

- step3:点击创建。

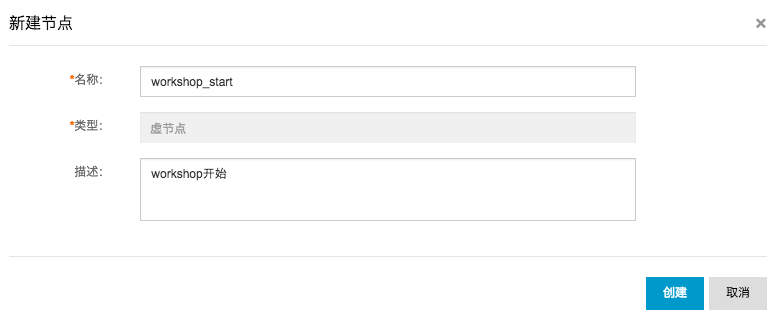

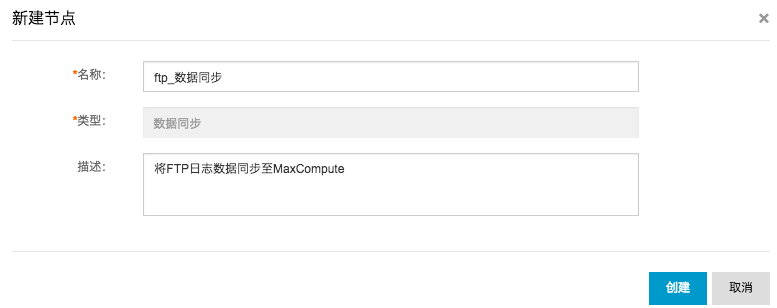

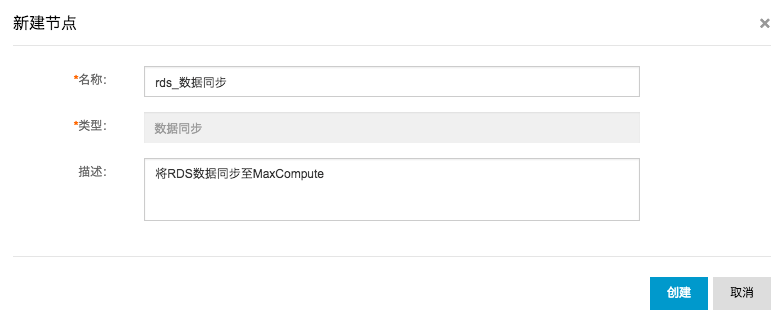

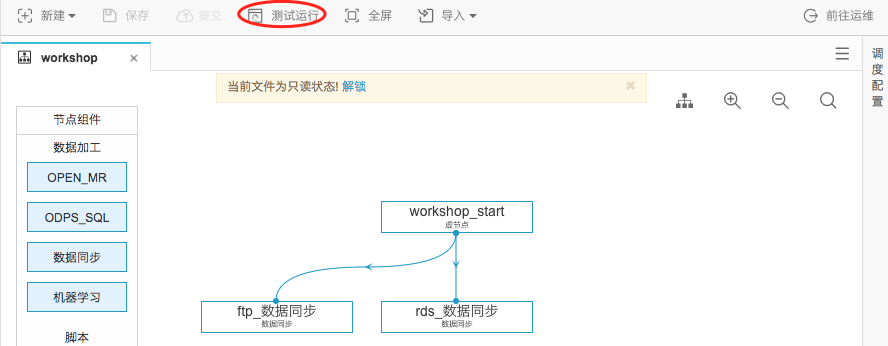

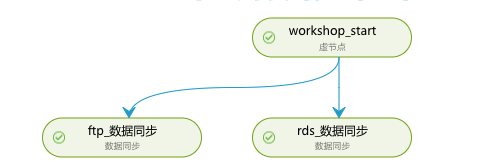

- step4:进入工作流配置面板,并向面板中拖入一个虚节点(命名为workshop_start)和两个数据同步节点(分别命名为ftp_数据同步和rds_数据同步):

- step5:拖拽连线将workshop_start虚节点设置为两个数据同步节点的上游节点,如下所示:

- step6:点击保存(或直接快捷键ctrl+s)。

配置数据同步任务

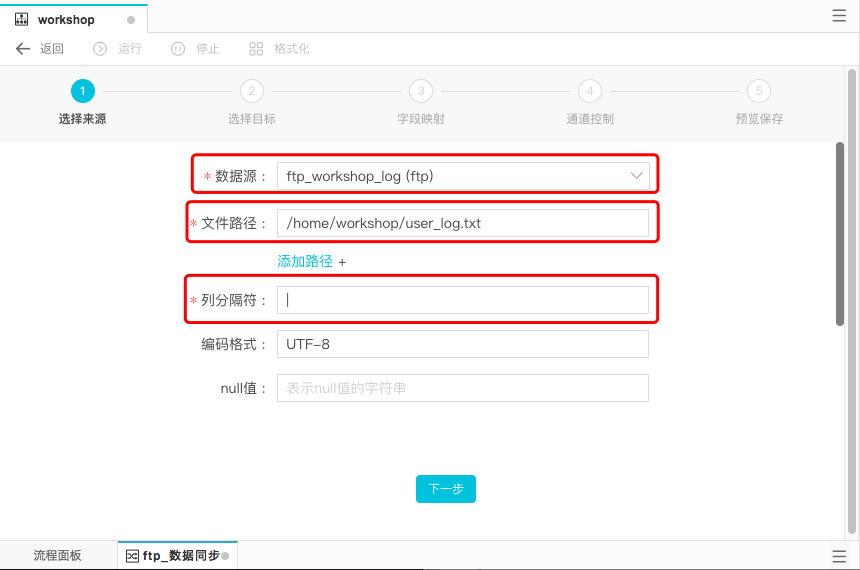

1)配置ftp_数据同步节点

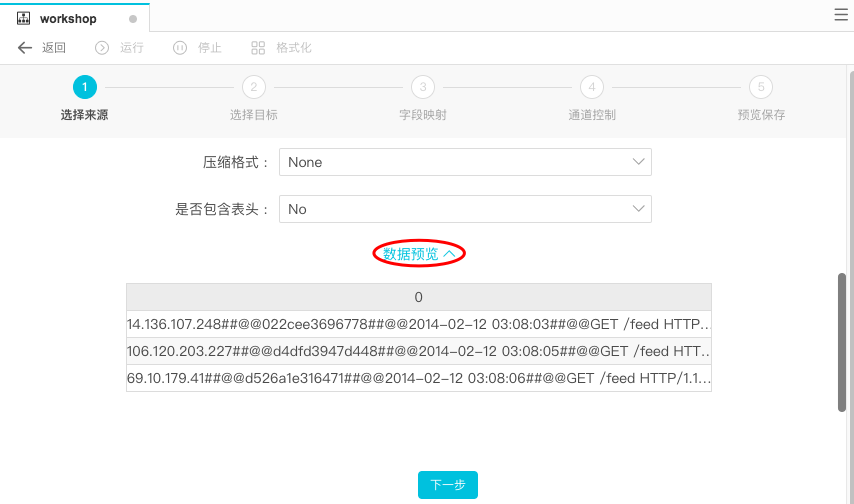

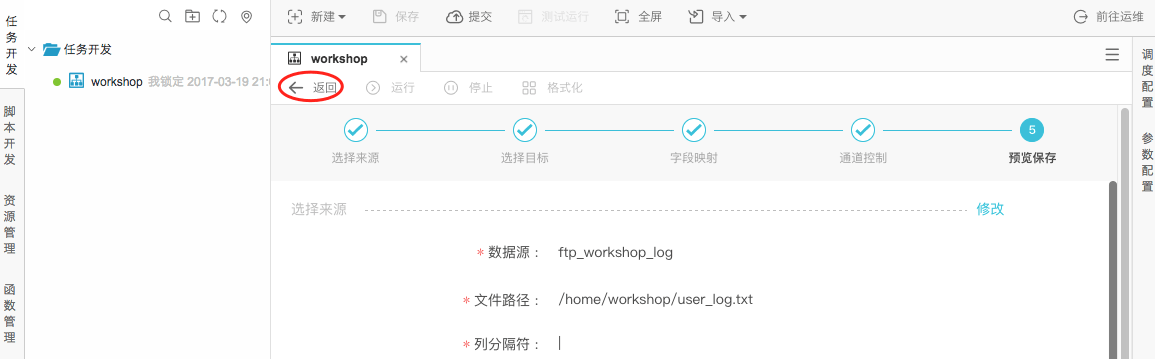

- step1:双击ftp_数据同步节点,进入节点配置界面。选择来源:并选择数据来源事先配置好的ftp数据源,为ftp_workshop_log,文件路径为/home/workshop/user_log.txt。可以对非压缩文件进行数据预览。

数据来源配置项具体说明如下:

- 数据来源:ftp_workshop_ftp

- 文件路径:/home/workshop/user_log.txt

- 列分隔符:|

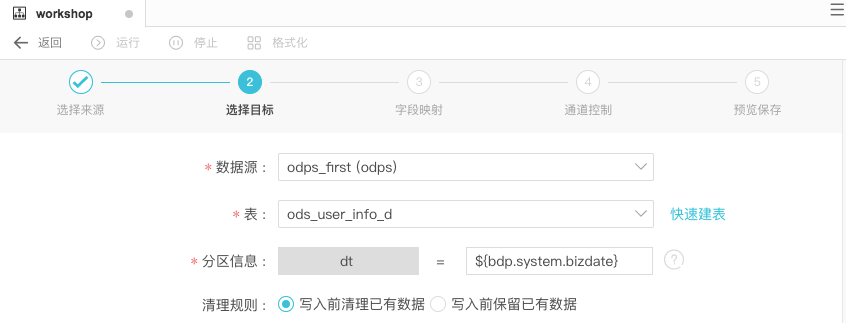

- step2:选择目标。点击下一步。

数据流向选择数据源为odps_first,表名为ods_raw_log_d。分区信息和清理规则都采取系统默认,即清理规则为写入前清理已有数据,分区按照${bdp.system.bizdate}。

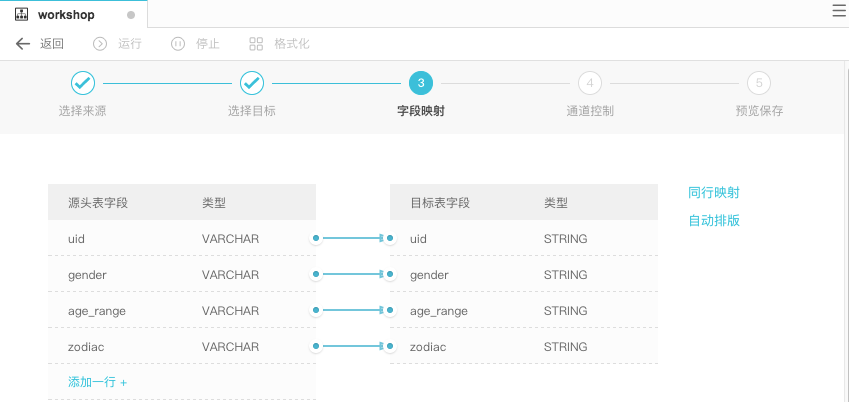

- step3:配置字段映射。连接要同步的字段。如下:

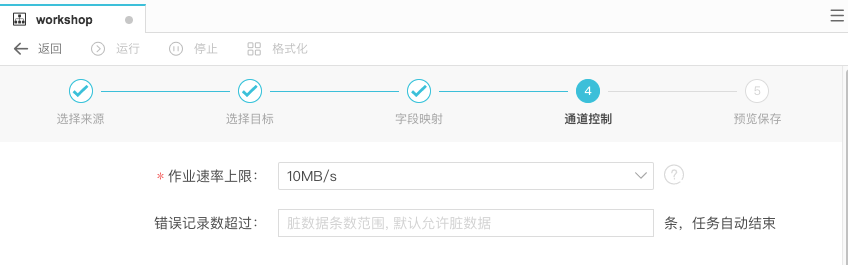

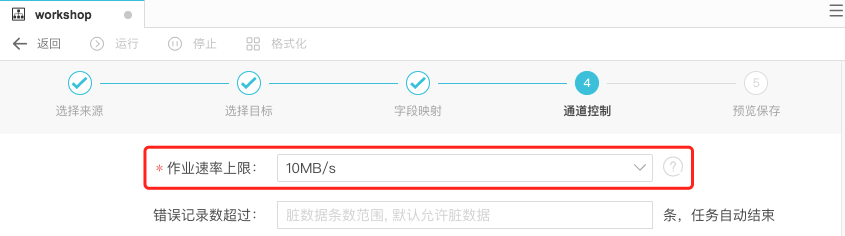

- step4:在下一步操作中配置通道控制,作业速率上限为10MB/s,进入下一步。

可在预览保存页面中,预览上述的配置情况,也可以进行修改,确认无误后,点击保存。

- step5:点击返回工作流面板。

2)配置rds_数据同步节点

- step1:双击rds_数据同步节点进入配置界面。选择来源:选择数据来源为rds_workshop_log,表名为ods_user_info_d;切分键为使用默认生成列即可。点击数据预览,可以看到表中数据样例。

- step2:进入下一步,选择目标数据源和表名。

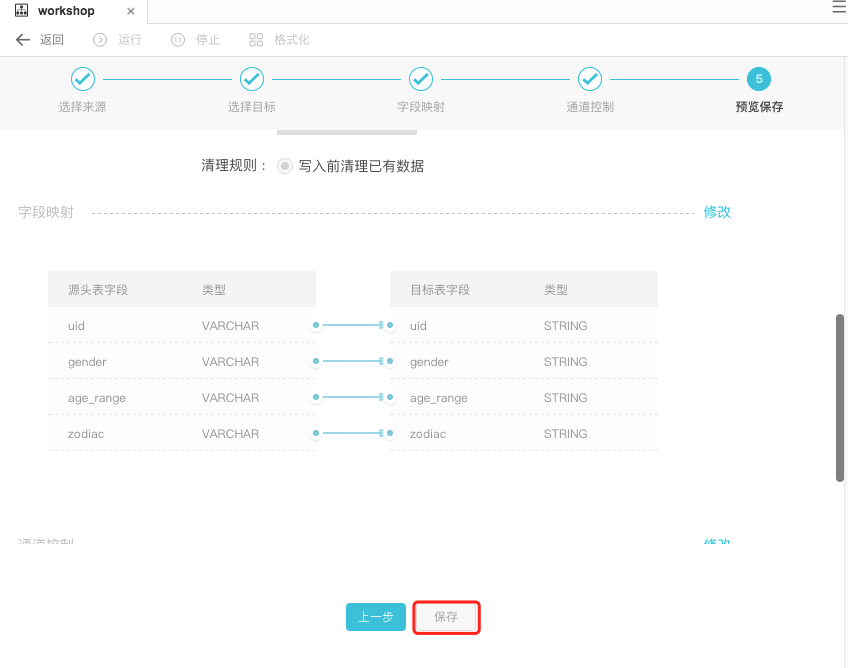

- step3:进入下一步,配置字段映射。默认会同名映射,字段映射关系采用默认即可,如下所示:

- step4:进入下一步,配置作业速率上限。

- step5:在预览保存页面中确认配置信息,无误后点击保存配置。

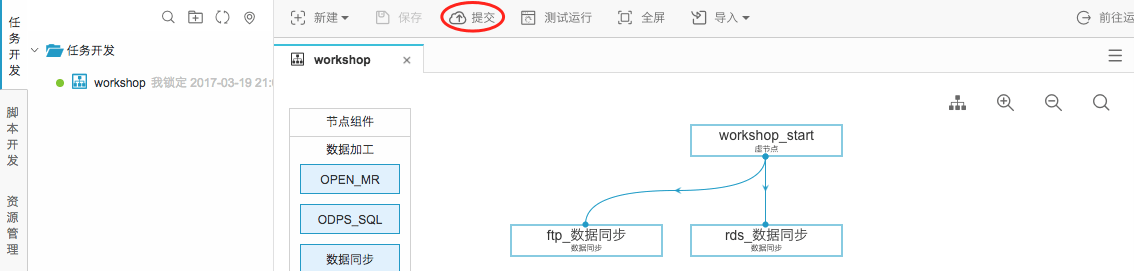

提交工作流任务

- step1:点击提交,提交已经配置的工作流任务。

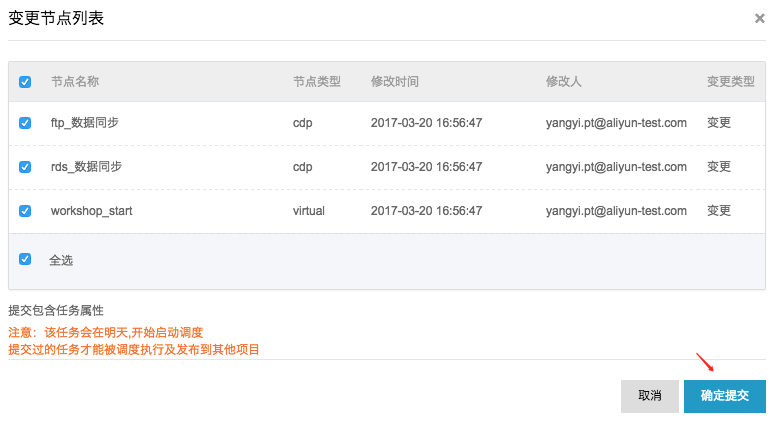

- step2:在变更节点列表弹出框中点击确定提交。

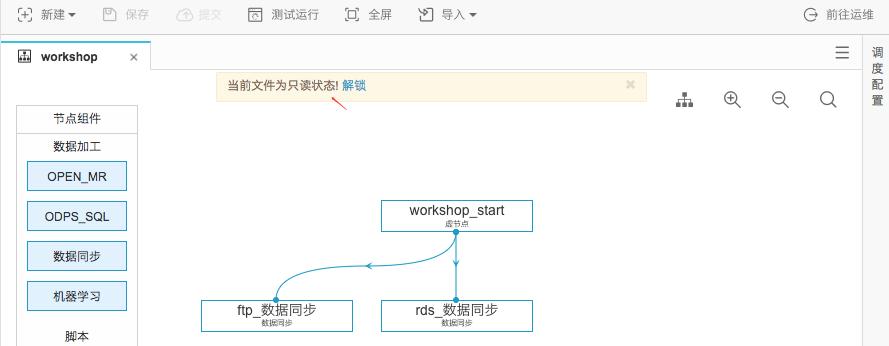

提交成功后工作流任务处于只读状态,如下:

测试运行工作流任务

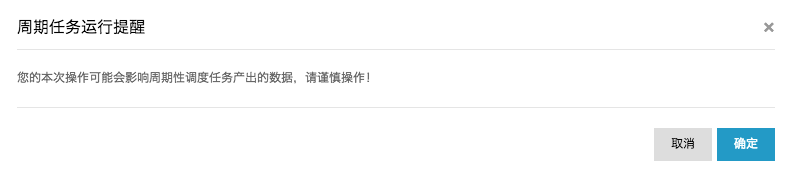

- step1:点击测试运行。

- step2:在周期任务运行提醒弹出框点击确定。

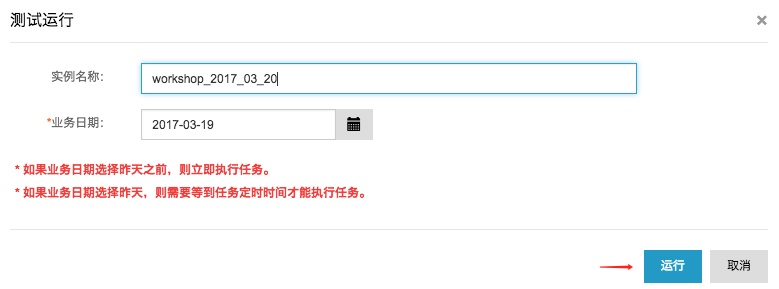

- step3:在测试运行弹出框中,实例名称和业务日期都保持默认,点击运行。

- step4:在工作流任务测试运行弹出框中,点击前往运维中心。

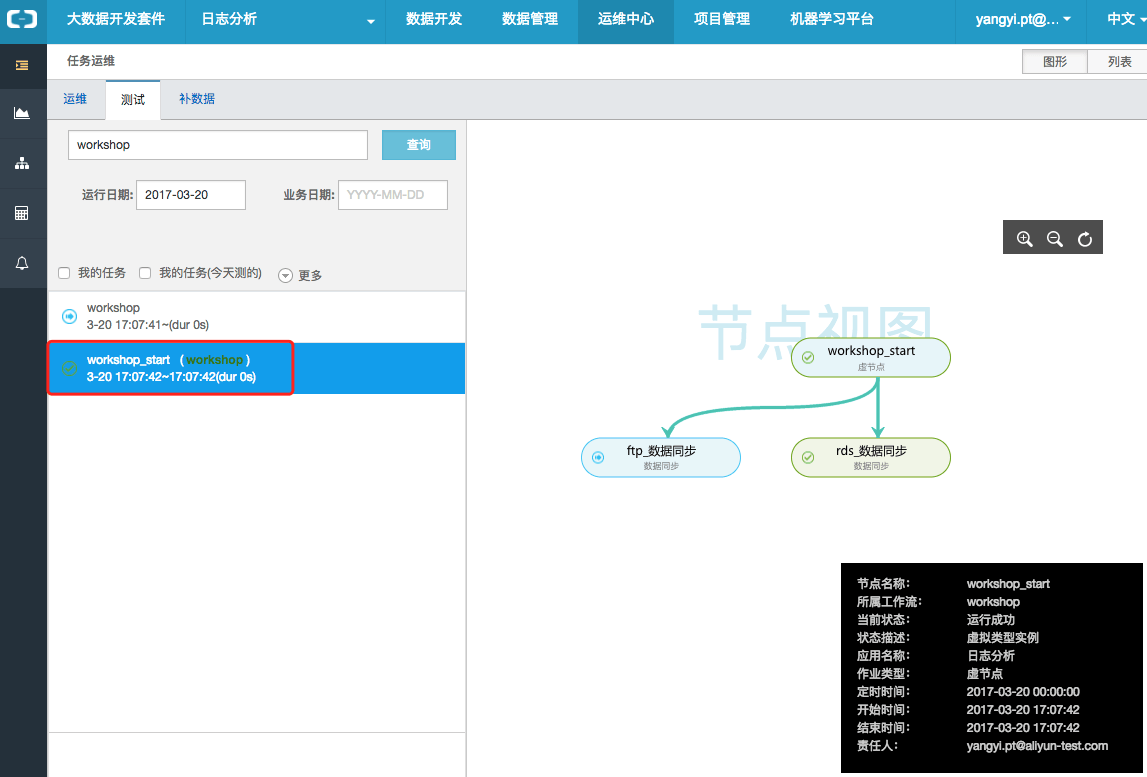

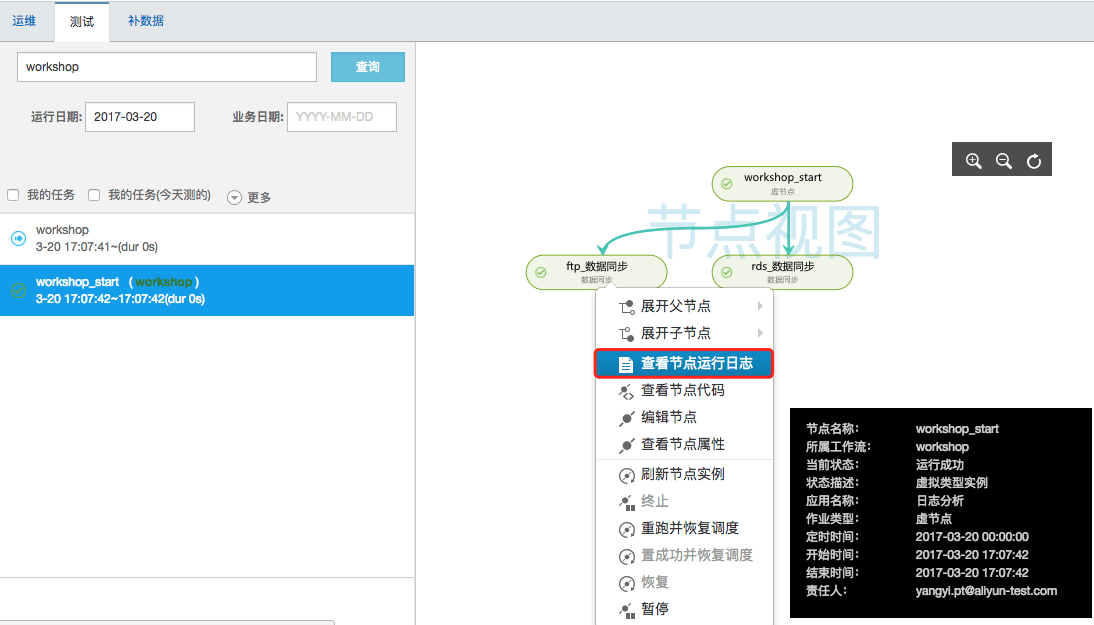

在运维中心可以查看任务视图,如下图表示该工作流任务(名称为workshop_start)正在运行。

直至所有节点都运行返回成功状态即可(需要点击运维视窗中的刷新按钮查看实时状态)。如下所示:

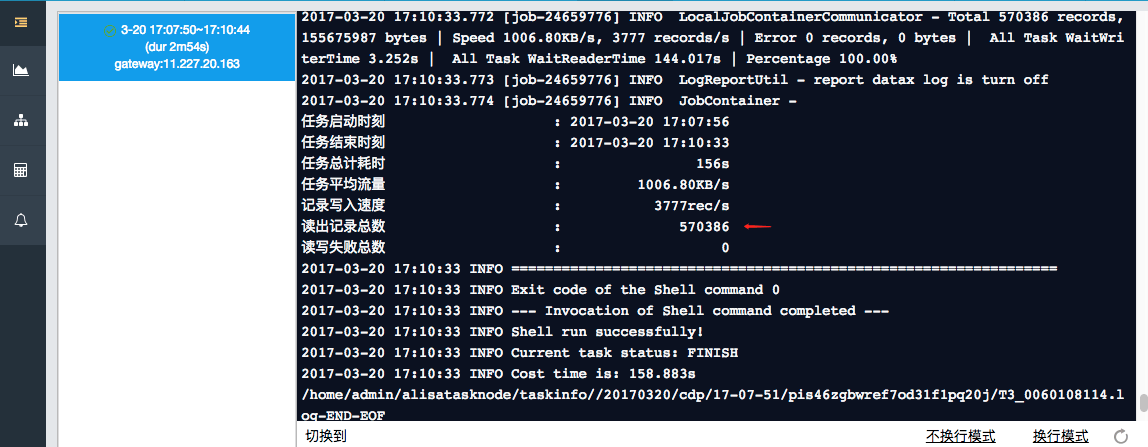

- step5:右键查看节点运行日志,可以看到成功同步数据条数。

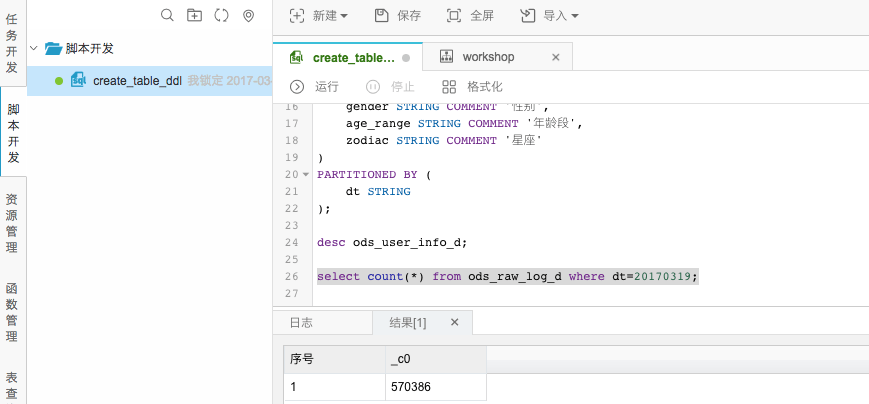

确认数据是否成功导入MaxCompute

- step1:返回到create_table_ddl脚本文件中。

- step2:编写并执行sql语句查看导入ods_raw_log_d记录数。

- step3:同样编写并执行sql语句查看导入ods_user_info_d记录数。

附录:SQL语句如下,其中分区键需要更新为业务日期,如测试运行任务的日期为20170328,那么业务日期为20170327.

---查看是否成功写入MaxComputeselect count(*) from ods_raw_log_d where dt=业务日期;select count(*) from ods_user_info_d where dt=业务日期;

《数据加工:用户画像》篇

转载地址:http://xfzel.baihongyu.com/

你可能感兴趣的文章

ExtJs3.3升级4.2

查看>>

列表上下滚动效果JS示例

查看>>

如何设计一门语言(一)——什么是坑(a)

查看>>

输入样例NYOJ 514 数字 1的个数

查看>>

博客属性10个非常不错的CSS技巧

查看>>

Windows 剪贴板的预定义格式

查看>>

Android网络类型判断(2g、3g、wifi)

查看>>

Jquery.KinSlideshow图片滚动

查看>>

实现多个jetty实例开机后自动启动

查看>>

hdu 4160(最小路径覆盖)

查看>>

从WindowsXP到Mac OS

查看>>

POJ 2253 Frogger (求每条路径中最大值的最小值,Dijkstra变形)

查看>>

linux网络编程之System V 信号量(三):基于生产者-消费者模型实现先进先出的共享内存段...

查看>>

Spring Data JPA教程, 第七部分: Pagination(未翻译)

查看>>

Mnesia基本用法

查看>>

VS2012下基于Glut OpenGL glEdgeFlag示例程序:

查看>>

【电子基础】单片机定时器实用方法总结

查看>>

设置tableViewCell背景颜色

查看>>

urses.ascii.ispunct(ch):

查看>>

在OpenStack虚拟机实例中创建swap分区的一种方法

查看>>